智东西(公众号:zhidxcom)

作者 | ZeR0 程茜

编辑 | 漠影

全球最大云计算巨头,今日掏出硬核家底!

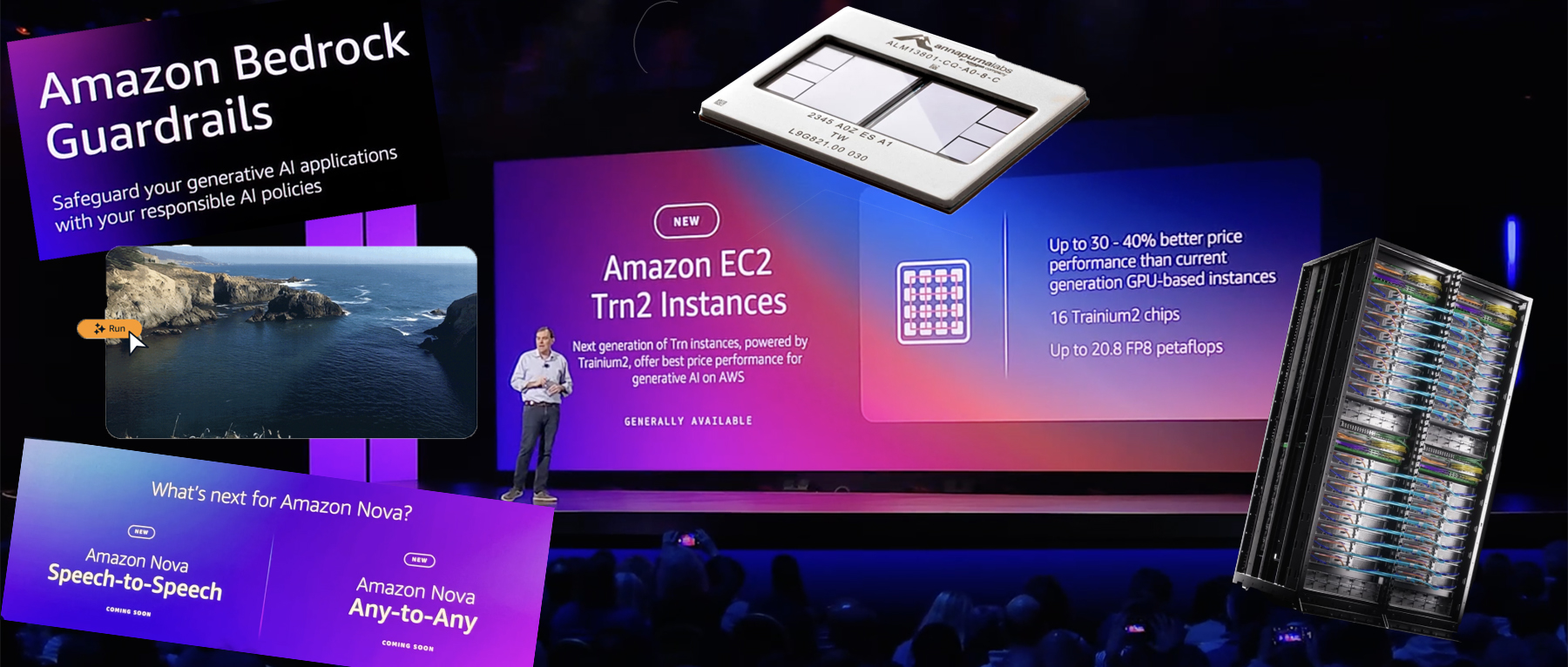

智东西12月3日拉斯维加斯报道,在年度云计算产业盛会AWS re:Invent大会上,AWS(亚马逊云科技)一口气发布6款大模型、预告2款大模型,还推出3nm第三代AI训练芯片Trainum3及其迄今最强AI服务器Trn2 UltraServer。

这是Amazon Nova系列基础模型首次亮牌。

包括Micro、Lite、Pro、Premier四个版本的语言模型,还有图像生成模型Canvas、视频生成模型Reel。其中Reel现支持生成6秒视频,很快将会延长到2分钟。

亚马逊总裁兼CEO安迪·贾西现场剧透:明年,AWS不仅将发布语音转语音模型,还有更高能的任意转任意(Any-to-Any)模型——能输入和输出文本、图像、音频、视频等任何模态的内容。

这些模型均在Bedrock中提供,可微调和蒸馏。

此外,AWS CEO马特·加曼宣布推出最新生成式AI实例Amazon EC2 Trn2,比当前基于GPU的EC2实例的性价比高出30%~40%。

苹果机器学习和人工智能高级总监Benoit Dupin来到现场,称苹果在iPad、Apple Music、Apple TV、新闻、App Store、Siri等产品和服务上广泛使用了亚马逊服务。

他特别分享道,与x86实例相比,苹果已用Amazon Graviton、Inferentia等AWS芯片在机器学习推理工作负载方面实现了40%以上的效率提升,并预计在Trainium 2上预训练模型时,效率将提高50%。

被亚马逊豪掷80亿美元投资的Anthropic,宣布与AWS共同构建面向机器学习训练的世界最大计算集群,其下一代Claude大模型将在拥有数十万颗Trainium2芯片的集群上进行训练。

总体来看,AWS的计算、存储、数据库、AI推理,四大板块都迎来一大波重要更新。

一、全新自研大模型Amazon Nova系列登场!文本、图像、视频齐活了

亚马逊总裁兼CEO安迪·贾西现场分享了生成式AI如何贯穿亚马逊不同业务,包括改善了电商客服、卖家详情页创建、库存管理、机器人、Alexa、Amazon Lens、线上购物衣服尺码匹配、Prime Video等的效率和体验。

然后,他公布全新大模型系列——Amazon Nova!

Nova语言模型有四款:

(1)Micro:纯文本模型,128k上下文窗口,延迟最低,响应速度最快。

(2)Lite:成本很低的多模态模型,300k上下文窗口,可快速处理图像、视频和文本输入。

(3)Pro:多模态模型,300k上下文窗口,兼顾准确度、速度和成本,能进行视频理解、生成创意素材。

(4)Premier:亚马逊功能最强的多模态模型,可用于执行复杂的推理任务,并可用作蒸馏自定义模型的最佳老师(将于2025年第一季度推出)。

据介绍,Micro、Lite和Pro的价格至少比Amazon Bedrock中各自智能类别中性能最佳的模型便宜75%。它们也是Amazon Bedrock中各自智能类别中速度最快的模型。

AWS称到2025年初,某些Nova模型的上下文窗口将扩展以支持超过200万个token。

在基准测试中,Micro版整体性能超过Gemini 1.5 Flash 8B和Llama 3.1 8B。

Lite在处理轻量级任务时是最低成本的多模态模型。

新发布的另外两个Nova模型是图形生成模型Canvas和视频生成模型Reel,可用于提升宣传广告的创意。

Canvas支持生成和编辑图像,提供配色方案和布局控件,并内置有安全控件,用于可追溯性的水印和用于限制有害内容生成的内容审核。

Reel可根据关键词或可选的参考图像生成6秒视频,支持用户调整摄像机运动以生成具有平移、360度旋转和缩放的视频。可制作2分钟视频的版本即将推出。

▲用Amazon Nova Reel创作的视频示例

这些模型支持自定义微调和蒸馏。

还有One More Thing:

AWS将在明年推出另外两款Nova模型,一款是“语音转语音”模型;另一款是“任意转任意”多模态模型,其输入和输出可以是文本、图像、音频或视频,也就是能用同一个模型执行各种任务。

除了发布自研模型,AWS也公布了跟Anthropic的合作新进展。

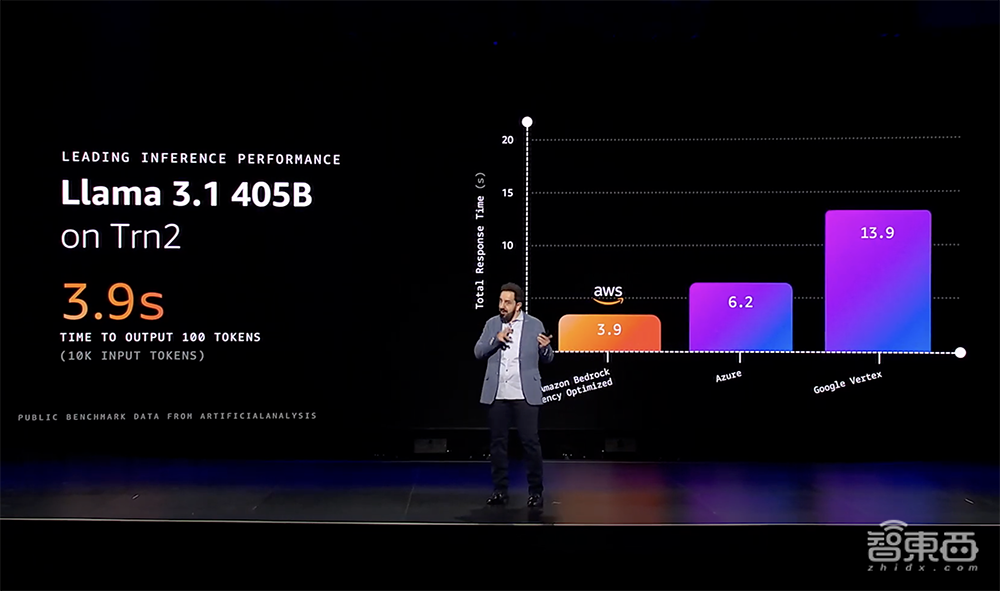

AWS与Anthropic合作推出了Claude 3.5 Haiku延迟优化版,将推理速度提高60%。

客户只需打开API的开关,请求就会被发到新的Trainium2服务器上。

Amazon Bedrock提供的延迟优化选项,支持客户访问其最新AI硬件和其他软件优化,以获得模型的最佳推理性能。除了Claude模型外,还包括Llama 405B和较小的Llama 270B模型,处理请求和生成相应的总耗时比其他产品低得多。

二、AWS Trainium2实例全面推出,发布第三代AI训练芯片、最强AI服务器

AWS全面推出由Trainium2芯片驱动的Amazon EC2 Trn2实例,相比当前基于GPU的EC2实例,性价比高出30%~40%。

全新Amazon EC2 Trn2实例专为包括大语言模型和潜在扩散模型在内的生成式AI高性能深度学习训练而构建。

其AI硬件全家桶也哐哐上新,推出第三代自研AI训练芯片Trainium3,还发布了其史上最强AI服务器Trn2 UltraServer。

1、第三代自研AI训练芯片

AWS发布了新一代AI训练芯片Trainium3。这是首款采用3nm工艺节点制造的AWS芯片,能效提高40%、性能翻倍提升。

搭载Trainium3的UltraServer性能预计将比Trn2 UltraServer高出4倍。首批基于Trainium3的实例预计将于2025年底上市。

2、最强AI服务器,64颗Trainium2合体

AWS发布其史上最强AI服务器AWS Trn2 UltraServer,能支撑万亿参数AI模型的实时推理性能。

全新Trn2 UltraServer使用超高速NeuronLink互连,将4台Trn2服务器连接在一起,形成1台巨型服务器,实现更快的大模型训练和推理。

单个Trn2实例结合了16颗Trainium2芯片,可提供20.8PFLOPS,适合训练和部署有数十亿个参数的大语言模型。

全新EC2产品Trn2 UltraServer则将64颗Trainium2芯片互连,可提供相比当前EC2 AI服务器多达5倍的算力和10倍的内存,将FP8峰值算力扩展到83.2PFLOPS(单个实例的4倍)。

AWS已与Adobe、AI软件开发平台Poolside、数据分析平台Databricks、高通等几个早期客户进行了Beta测试培训。

3、与Anthropic扩大合作,要建全球最大AI计算集群

美国AI大模型独角兽Anthropic的联合创始人兼CTO Tom Brown现场分享说,就像俄罗斯方块游戏,机器内部构造越紧密,跑模型就越便宜越快。一年多来,Anthropic性能工程团队与亚马逊和Annapurna团队密切合作,应对这一挑战。

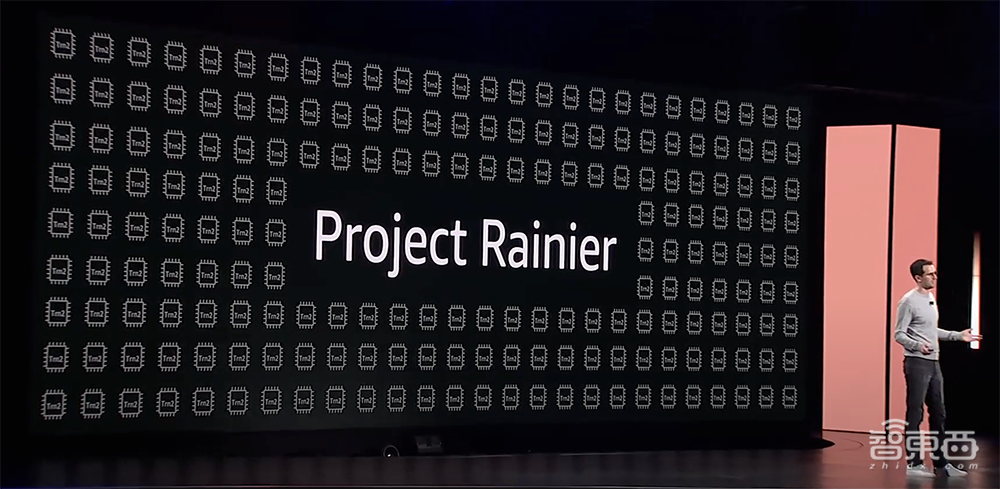

他宣布AWS与Anthropic正合作构建一个名为Project Rainier的Trn2 UltraServers EC2 UltraCluster,它将在数十万颗Trainium2芯片上扩展分布式模型训练。

这些芯片与第三代低延迟PB级EFA网络互连,是Anthropic用于训练其当前一代领先AI模型的百亿亿次浮点运算数量的5倍多。

建成后,预计它将成为迄今世界上最大的AI计算集群,可供Anthropic构建和部署其未来模型。

使用Project Rainer后,用户将能够以更低价格、更快速度获得更多智能、更聪明的Agent。

4、新一代AI网络结构tnp10

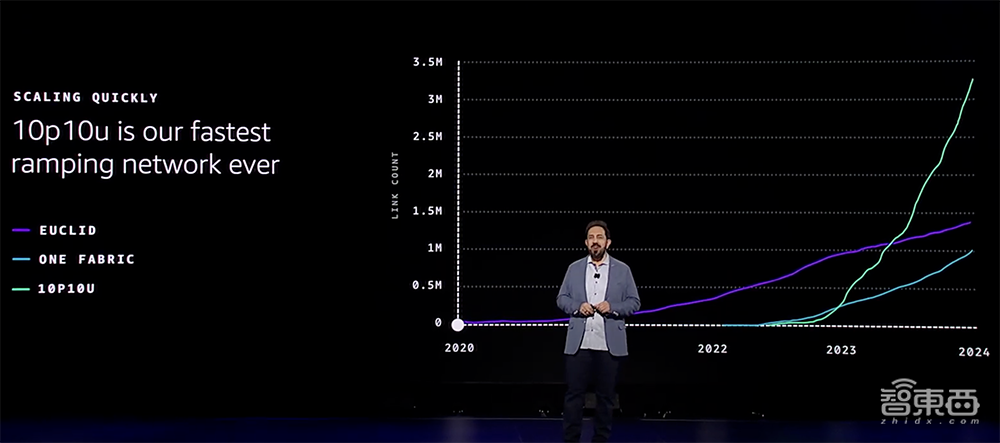

为Trainium2 UltraServer提供动力的是最新一代AI网络结构tnp10。AWS在基于Trainium和NVIDIA芯片的集群都使用了这个网络。它能在10微秒延迟下为数千台服务器提供数十PB网络容量,实现了AWS迄今扩展速度最快的网络。

Tnp10网络的大规模并行、紧密互联和弹性的,可缩小到几个机架,也可以将其扩展到跨越多个物理数据中心园区的集群。

AI网络中的最大故障来源是光链路。多年来,AWS一直在设计和运行自家定制光学系统,以持续降低故障率。为了进一步优化网络,AWS在tnp10网络中建立了一个全新的网络路由协议“可扩展意图驱动路由(CIDR)”,通过分散的速度和弹性提供了集中的计划、控制和优化。

三、生成式AI平台Bedrock服务三大更新:自动推理检查、多Agent协同、模型蒸馏

AWS Bedrock服务可帮助企业构建和扩展生成式AI应用程序,今天公布关于自动推理检查、多agent协作、模型蒸馏的新功能。

AWS将Bedrock标榜为“构建生成式AI应用的最简单方式”。据加曼透露,每天都有成千上万的客户将Bedrock用于生产应用程序,这几乎是去年一年增长率的5倍。

1、自动推理检查,可预防AI幻觉

AI幻觉是妨碍AI应用进入企业实际生产的关键。AWS在探索过程中发现,自动推理可以被应用于解决这个问题。自动推理通常用于证明系统是否按指定方式工作。这个工具可以自动检查方案和软件,验证在遇到意外事件时如何正确响应等。

基于此,AWS推出了AWS Automated Reasoning checks,可验证事实响应的准确性、生成可审计的输出,并向客户展示模型得出结果的确切原因。

同时,Amazon Bedrock会自动制定必要的规则,引导客户对其进行迭代测试,以确保模型调整到正确的响应。

2、多Agent协作,1小时完成此前1周任务

Bedrock的新功能还有帮助企业轻松构建、部署、编排agent团队,使其写作解决复杂多步骤任务。

使用Amazon Bedrock multi-agent collaboration,企业可通过为项目的特定步骤创建和分配专门Agent来获得更准确的结果,并通过协调多个并行工作的Agent来加速任务。

比如企业可以在Bedrock上构建自己的专业Agent,然后创建主管Agent或协调Agent来帮助管理其他Agent。

AWS的客户称,这种多Agent协作使其此前需要大约1周时间的相同任务,现在可以在1小时内完成。

3、模型蒸馏,速度最高提升500%

当下每周都有新版本的模型发布,企业需要基于自己的实际需求找到更适合的模型,需要适当的专业知识、适当延迟、适当成本以完成任务。

企业目前解决的方案之一是模型蒸馏,将性能强大的基础模型中的数据和答案拿出来训练更小的模型,这需要企业对训练数据进行管理,并同时考虑到模型参数和权重的问题。

借助Amazon Bedrock Model Distillation,客户只需针对给定用例选择最佳模型,并从同一模型系列中选择较小的模型,即可以合适的成本提供其应用程序所需的延迟。

与原始模型相比,蒸馏模型速度最高可提高500%,运行成本降低75%,对于检索增强生成(RAG)等用例,准确度损失不到2%。

四、Amazon Q Developer超越代码,覆盖更广泛开发任务

Amazon Q Developer辅助编程平台此次升级的重点是超越代码完成,帮助开发人员完成端到端软件生命周期中涉及的更广泛日常任务。

Amazon Q Developer的新功能主要包括:

- 将Windows .NET应用程序现代化为Linux,速度提高4倍,并将许可成本降低多达40%。

- 将VMware工作负载转变为云原生架构,agents自动规划、鉴别、决定和转换网络配置,在数小时内将本地网络配置转换为AWS等效配置。

- 通过简化代码分析、文档、规划和重构应用程序等劳动密集型工作来加速大型机现代化。

Q Developer现可自动生成单元测试,并帮助开发人员编写和维护代码文档。它可以生成第一个代码审查,供开发人员提交代码时使用。一旦代码投入生产,Q的新运营Agent就自动从公司的监控服务AWS CloudWatch中提取数据,并在警报响起时立即开始调查。

AWS还推出了一款用于现代化COBOL大型机应用程序的Agent。

此外,开发人员和安全平台GitLab和AWS宣布已联手将GitLab的Duo AI助手与亚马逊的Q自主Agent结合起来。GitLab用户可用Duo的聊天功能访问Amazon Q Developer中提供的许多Agent,以帮助进行代码审查、生成单元测试和现代化他们的Java应用程序,该功能现在已直接集成到GitLab聊天UI中。

五、与英伟达合作14年,明年初发布Blackwell架构P6实例

AWS将核心服务通过构建block提供,企业可以更容易将这些服务进行组合,并建立真正有趣的应用。这个构建Block的概念一直是AWS构建服务、支持客户运行的基础,目前其已经提供了大量服务模块。

例如,在生物领域,AWS开发了ESM模型系列,帮助全球科学家理解和设计蛋白质。ESM3已经被训练了1万亿兆兆次,计算了超20亿个蛋白质序列,这意味着科学家可以像设计芯片一样设计蛋白质,朝着生物可编程迈出一步。

加曼谈到企业选择AWS的一个重要原因就是安全。重视安全是AWS开展业务的基础,这关系到其如何设计数据中心、芯片、虚拟化堆栈以及服务体系结构。

在这之上,截至目前,AWS提供了比任何供应商都更多的计算资源。亚马逊EC2拥有更多选项、实例和功能,可以让企业找到适合其工作负载的应用程序的对应性能。

例如,企业正在运行一个用于分析工作流的大型数据库,AWS可以在任何地方运行最大的存储系统;如果企业正在运行一个HPC集群、大模型以及所有集群,并需要快速的网络将这些东西进行连接,而AWS拥有订购速度最快的熟练网络。

AWS自研芯片为其提供了更大的灵活性,当其单独移动Nitro系统中的虚拟化设计时,可以无需重做虚拟化堆栈。基于新的实例类型,快速、简单的进行开发。

AWS的Graviton系列处理器目前已经被几乎所有的AWS客户广泛使用,其性价比提高了40%。Graviton可以处理更广泛的工作负载,包括标量代码、数据库等。

目前,绝大多数的模型运行在英伟达的GPU之上,AWS和英伟达合作已经14年,加曼宣布其合作升级,发布P6实例。P6系列将采用新Blackwell芯片,明年初发布,P6实例将提供最多2个,计算速度比当前一代GPU快5倍。

六、Amazon S3存储功能扩展,更快数据湖分析、自动元数据生成

AWS致力于推出简单可扩展的存储方式。它在2006年推出的Amazon S3从根本上改变管理数据的想法,这一服务过去十几年来爆炸式增长。Amazon S3 Intelligent-Tiering智能分层已为客户节省40亿美元。

在此基础上,AWS推出Amazon S3 Tables功能,使S3成为首个完全托管支持Apache Iceberg的云对象存储,可实现更快分析,并以最简单的方式存储和管理任何规模的表(Table)数据。

许多客户将用于分析的数据组织为表数据,通常存储在Apache Parquet中。Parquet已是S3中增长最快的数据类型之一,Iceberg已成为管理Parquet文件的最流行的开放表格式(OTF)。

AWS将S3 Tables称作“对S3中的Apache Iceberg表执行分析的最简单快捷的方法”。它专为管理数据湖的Apache Iceberg表而构建,是第一个具有内置Apache Iceberg表支持的云对象存储并引入了一种新的存储桶类型,来优化以Iceberg表形式存储和查询表数据。

与通用S3存储桶相比,S3 Tables可提供3倍的查询性能、10倍的每秒事务数(TPS),并会自动管理表维护任务。

AWS还推出了Amazon S3 Metadata,可以近乎实时地自动生成可查询的目标元数据(metadata),并使其可通过新S3 Tables进行查询,让发现和管理S3中的海量数据变得更简单快捷。

S3 Tables(正式发布)、S3 Metadata(预览版)现已推出,与Apache Iceberg表兼容,支持用AWS分析服务和开源工具轻松查询数据。

七、两大数据库上新:能跨区域运行,具备强一致性

AWS今日宣布推出Amazon Aurora DSQL和Amazon DynamoDB global tables新功能,以支持一些工作负载对跨区域运行、强一致性、低延迟、高可用性的严苛需求,两个数据库的跨区域强一致性功能现已推出预览版。

今年是Amazon Aurora发布的十周年。它是迄今发展最快的AWS服务。每天有数十万客户依赖的Amazon Aurora,提供了企业级商用数据库的性能以及开源的灵活性和经济性。

如今AWS再次重新构想关系数据库,让客户无需在低延迟或SQL之间做选择。

Amazon Aurora DSQL是一种新型无服务器分布式SQL数据库,既可以提供高端商用数据库的所有性能和功能,又具有开源数据库的灵活性和成本效益。

与其他流行的分布式SQL数据库相比,Aurora DSQL的读写速度快至4倍,多区域可用性高达99.999%,可扩展性几乎无限,而且无需管理基础设施,无需配置、修补或管理数据库实例。

Aurora DSQL克服了分布式数据库的两个历史挑战——实现多区域低延迟强一致性,以及在全球范围内以微秒级精度同步服务器。

该数据库通过将事务处理与存储分离来克服当前方法的局限性,仅在提交时检查每个事务,并在提交时并行化所有区域的所有写入,以提供具有强一致性和快速写入的多区域数据库,且所有更新和安全修补都无需停机,也不会对性能产生任何影响。

为了确保每个区域都能按照发生的确切顺序看到每个数据库操作,Aurora DSQL使用了Amazon Time Sync Service,该服务在每个 Amazon EC2实例上添加了硬件参考时钟,将它们同步到与卫星连接的原子钟,以提供世界任何地方的微秒级精确时间。

Amazon DynamoDB第一个完全托管的无服务器NoSQL数据库,通过重新定义性能和简化操作,在任何规模下都无需基础设施管理,并且始终保持个位数毫秒级的性能。

该数据库现支持多区域强一致性,确保客户的多区域应用程序始终读取最新数据,而无需更改任何应用程序代码。

八、面向高密度AI工作负载,推出全新灵活数据中心组件

AWS宣布推出全新数据中心组件(电源、冷却、硬件设计),旨在支持高密度AI工作负载。

(1)简化电气和机械设计:使基础设施可用性达到99.9999%,还将可能受电气问题影响的机架数量减少了89%。

(2)冷却、机架设计和控制系统的创新:开发全新可配置液冷解决方案,通过优化数据中心机架的定位方式来最大限度利用电力,更新了标准化监控、报警和操作顺序的控制系统。

(3)提高能源效率和可持续性:与之前的设计相比,预计在峰值冷却条件下机械能消耗可降低多达46%;与行业平均水平相比,数据中心建筑外壳混凝土中的隐含碳减少35%;备用发电机将能够使用可生物降解且无毒的可再生柴油燃料。

结语:一场大型科技创新秀场

历届AWS re:Invent大会,都是计算、安全、存储系统和AI基础设施等的大型创新秀场。

从2003年秋天启程开始,AWS不断降低云服务的门槛,将大公司级成本结构和规模的基础设施变成人人随处可得,让大中小型企业团队不必在计算、存储、数据库、分析等方面重复造轮子。

在全栈创新的深度和产品组合的广度,使得这家云大厂能够持续巩固高性能、节能、安全、合规、扩展性等方面的可信赖度,并跟上快速变化的AI需求,有足够的经验和能力来帮助客户更好地专注于自身业务和适应创新。